评估报告参考

图像分类模型评估报告

模型评估报告内容说明

模型训练完成后我们可以在模型列表中看到模型效果及查看模型评估报告的入口。进入模型评估报告页面,我们可以看到整体报告内容中包含以下几个区域内容:

模型基本信息

在这个部分可以选择应用类型、训练版本

整体评估

在这个部分可以看到模型训练整体的情况说明,包括基本结论、准确率、F1-score、精确率、召回率。这部分模型效果的结果内容是基于训练数据集,随机抽出部分数据不参与训练,仅参与模型效果评估计算得来。所以当数据量较少时(如图片数量低于100个),参与评估的数据可能不超过30个图片,这样得出的模型评估报告效果仅供参考,无法完全准确体现模型效果。

注意:若想要更充分了解模型效果情况,建议发布模型为API后,通过调用接口测试批量图片数据获取更准确的模型效果。

详细评估

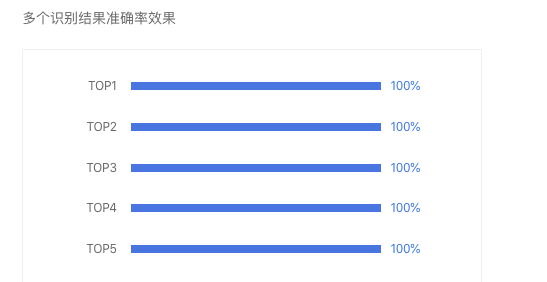

在这个部分可以看到上述训练效果背后的原始评估数据。以及不同top结果的准确率效果情况,下面为相关名词解释。

图像分类名词解释

准确率

准确率含义为正确分类的样本数与总样本数之比,这里指的总样本是指从总训练数据中随机抽取部分数据参与模型评估的总样本,在上文截图中,参与训练的图片数200个,实际参与评估的数据为下面详细评估预测表现表格的数据总和,即50个。那么准确率为参与评估的正确数量46/50,结果为92.0%

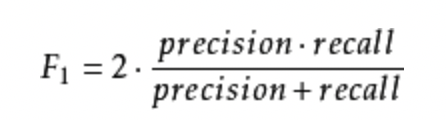

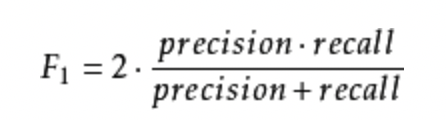

F1-Score

F1-score是指对某类别而言为精确率和召回率的调和平均数,此处为各类别F1-score的平均数。 就某类而言,精确率和召回率体现了该分类的精确率及召回率的平衡情况:

精确率

精确率是对某类别而言为正确预测为该类别的样本数与预测为该类别的总样本数之比,此处为各类别精确率的平均数。如果精确率比较低,有一定可能原因为不同类别效果存在差异所致,请检查下不同类型样本量是否均衡。

召回率

召回率是指对某类别而言为正确预测为该类别的样本数与该类别的总样本数之比,此处为各类别召回率的平均数。

top1、top2、top…5

是指对于每一个评估的图片文件,模型会给根据置信度高低,依次给出top1-top5的识别结果,其中top1置信度最高,top5的置信度最低。那么top1的准确率值是指对于评估标准为“top1结果识别为正确时,判定为正确”给出准确率。top2准确率值是指对于评估标准为“top1或者top2只要有一个命中正确的结果,即判定为正确”给出的准确率。……以此类推。

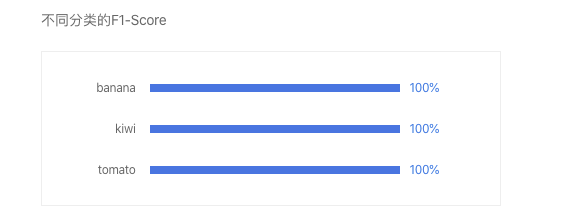

不同分类的F1-score

这个部分很重要,如果不同分类的F1-score存在差异很大的情况下,整体模型效果有被低精度的分类效果拉低的可能。建议检查训练数据中不同标签的目标数情况,建议不同分类的目标数尽可能均衡。

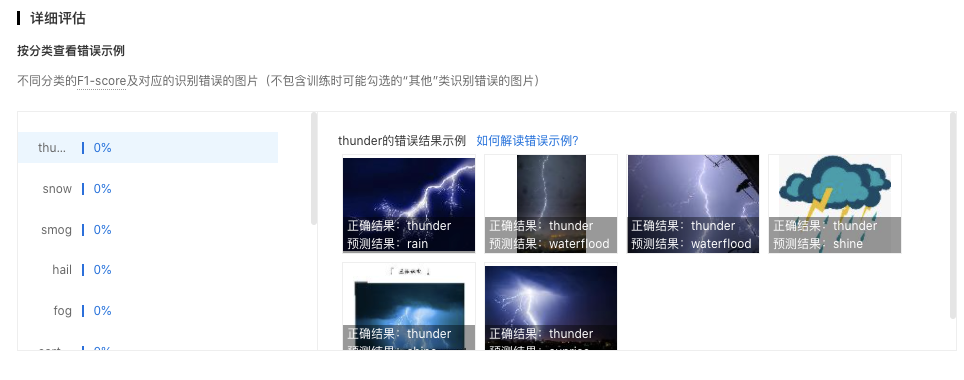

识别错误图片示例

通过分标签查看模型识别错误的图片,寻找其中的共性,进而有针对性的扩充训练数据。

例如,你训练了一个将小番茄和樱桃分类的模型。在查看小番茄分类的错误示例时,发现错误示例中有好几张图片都是带着绿色根茎的小番茄(与樱桃比较相似)。这种情况下,就需要在小番茄分类的训练集中,多增加一些带绿色根茎的图片,让模型有足够的数据能够学习到带根茎的小番茄和樱桃的区别。

这个例子中,我们找到的是识别错误的图片中,目标特征上的共性。除此之外,还可以观察识别错误的图片在以下维度是否有共性,比如:图片的拍摄设备、拍摄角度,图片的亮度、背景等等。

物体检测模型评估报告

模型评估报告内容说明

模型训练完成后我们可以在模型列表中看到模型效果及查看模型评估报告的入口。进入模型评估报告页面,我们可以看到整体报告内容中包含以下几个区域内容:

模型基本信息

在这个部分可以选择应用类型、训练版本

整体评估

在这个部分可以看到模型训练整体的情况说明,包括基本结论、准确率、F1-score、精确率、召回率。这部分模型效果的结果内容是基于训练数据集,随机抽出部分数据不参与训练,仅参与模型效果评估计算得来。所以当数据量较少时(如图片数量低于100个),参与评估的数据可能不超过30个图片,这样得出的模型评估报告效果仅供参考,无法完全准确体现模型效果。

注意:若想要更充分了解模型效果情况,建议发布模型为API后,通过调用接口测试批量图片数据获取更准确的模型效果。

物体检测名词解释

mAP

mAP(mean average precision)是物体检测(Object Detection)算法中衡量算法效果的指标。对于物体检测任务,每一类object都可以计算出其精确率(Precision)和召回率(Recall),在不同阈值下多次计算/试验,每个类都可以得到一条P-R曲线,曲线下的面积就是average

F1-Score

F1-score是指对某类别而言为精确率和召回率的调和平均数,此处为各类别F1-score的平均数。 就某类而言,精确率和召回率体现了该分类的精确率及召回率的平衡情况:

精确率

经比较F1-score最高的阈值0.3下的结果。精确率为该阈值下正确预测的物体数与预测物体总数之比

召回率

经比较F1-score最高的阈值0.3下的结果。召回率为该阈值下正确预测的物体数与真实物体数之比

阈值

阈值,是正确结果的判定标准,例如阈值是0.6,置信度大于0.6的识别结果会被当作正确结果返回。每个物体检测模型训练完毕后会给出建议阈值,建议后续在模型校验及正式调用服务过程中,阈值参数按照模型评估报告中的建议阈值进行配置。

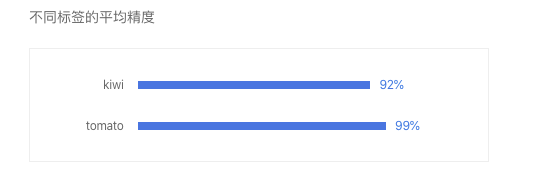

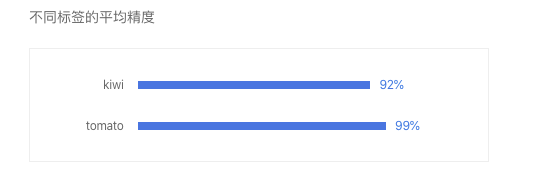

不同标签的平均精度

这个部分很重要,通过查看不同标签的平均精度可以有效观测不同标签的精度对比。如果存在精度差异很大的情况下,整体模型效果有被低精度的标签效果拉低的可能。建议检查训练数据中不同标签的目标数情况,建议不同标签的目标数尽可能均衡。

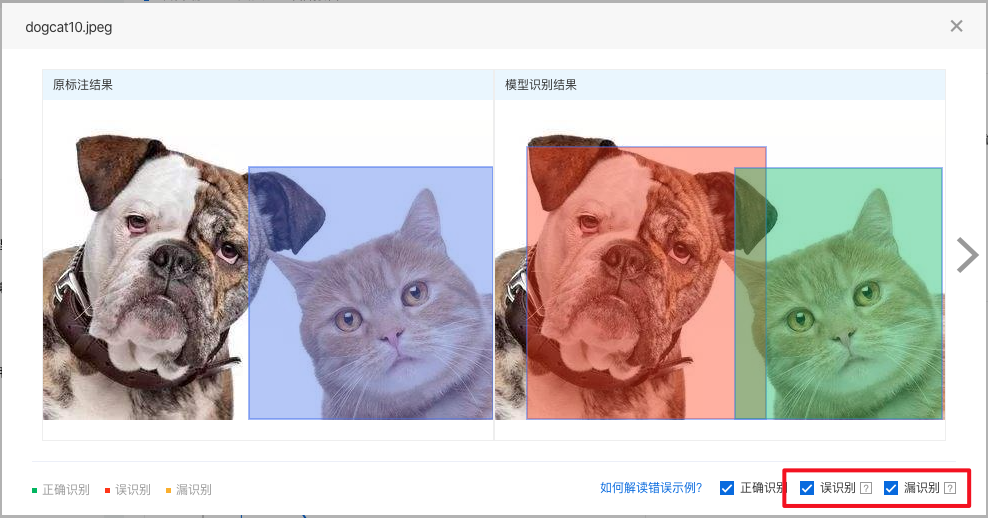

识别错误图片示例

通过分标签查看模型识别错误的图片,寻找其中的共性,进而有针对性的扩充训练数据。

如下图所示,可以通过勾选「误识别」、「漏识别」来分别查看两种错误识别的情况:

- 误识别:红框内没有目标物体(准备训练数据时没有标注),但模型识别到了目标物体

观察误识别的目标有什么共性:例如,一个检测电动车的模型,把很多自行车误识别成了电动车(因为电动车和自行车外观上比较相似)。这时,就需要在训练集中为自行车特别建立一个标签,并且在所有训练集图片中,将自行车标注出来。

可以把模型想象成一个在认识世界的孩童,当你告诉他电动车和自行车分别是什么样时,他就能认出来;当你没有告诉他的时候,他就有可能把自行车认成电动车。

- 漏识别:橙框内应该有目标物体(准备训练数据时标注了),但模型没能识别出目标物体

观察漏识别的目标有什么共性:例如,一个检测会议室参会人数的模型,会漏识别图片中出现的白色人种。这大概率是因为训练集中缺少白色人种的标注数据造成的。因此,需要在训练集中添加包含白色人种的图片,并将白色人种标注出来。

黄色人种和白色人种在外貌的差别上是比较明显的,由于几乎所有的训练数据都标注的是黄色人种,所以模型很可能认不出白色人种。需要增加白色人种的标注数据,让模型学习到黄色人种和白色人种都属于「参会人员」这个标签。

以上例子中,我们找到的是识别错误的图片中,目标特征上的共性。除此之外,还可以观察识别错误的图片在以下维度是否有共性,比如:图片的拍摄设备、拍摄角度,图片的亮度、背景等等。

实例分割模型评估报告

模型评估报告内容说明

模型训练完成后我们可以在模型列表中看到模型效果及查看模型评估报告的入口。进入模型评估报告页面,我们可以看到整体报告内容中包含以下几个区域内容:

模型基本信息

在这个部分可以选择应用类型、训练版本

整体评估

在这个部分可以看到模型训练整体的情况说明,包括基本结论、准确率、F1-score、精确率、召回率。这部分模型效果的结果内容是基于训练数据集,随机抽出部分数据不参与训练,仅参与模型效果评估计算得来。所以当数据量较少时(如图片数量低于100个),参与评估的数据可能不超过30个图片,这样得出的模型评估报告效果仅供参考,无法完全准确体现模型效果。

注意:若想要更充分了解模型效果情况,建议发布模型为API后,通过调用接口测试批量图片数据获取更准确的模型效果。

实例分割名词解释

mAP

mAP(mean average precision)是实例分割(Instance Segmentation)算法中衡量算法效果的指标。对于实例分割任务,每一类object都可以计算出其精确率(Precision)和召回率(Recall),在不同阈值下多次计算/试验,每个类都可以得到一条P-R曲线,曲线下的面积就是average

F1-Score

F1-score是指对某类别而言为精确率和召回率的调和平均数,此处为各类别F1-score的平均数。 就某类而言,精确率和召回率体现了该分类的精确率及召回率的平衡情况:

精确率

经比较F1-score最高的阈值0.3下的结果。精确率为该阈值下正确预测的物体数与预测物体总数之比

召回率

经比较F1-score最高的阈值0.3下的结果。召回率为该阈值下正确预测的物体数与真实物体数之比

阈值

阈值,是正确结果的判定标准,例如阈值是0.6,置信度大于0.6的识别结果会被当作正确结果返回。每个实例分割模型训练完毕后会给出建议阈值,建议后续在模型校验及正式调用服务过程中,阈值参数按照模型评估报告中的建议阈值进行配置。

不同标签的平均精度

这个部分很重要,通过查看不同标签的平均精度可以有效观测不同标签的精度对比。如果存在精度差异很大的情况下,整体模型效果有被低精度的标签效果拉低的可能。建议检查训练数据中不同标签的目标数情况,建议不同标签的目标数尽可能均衡。

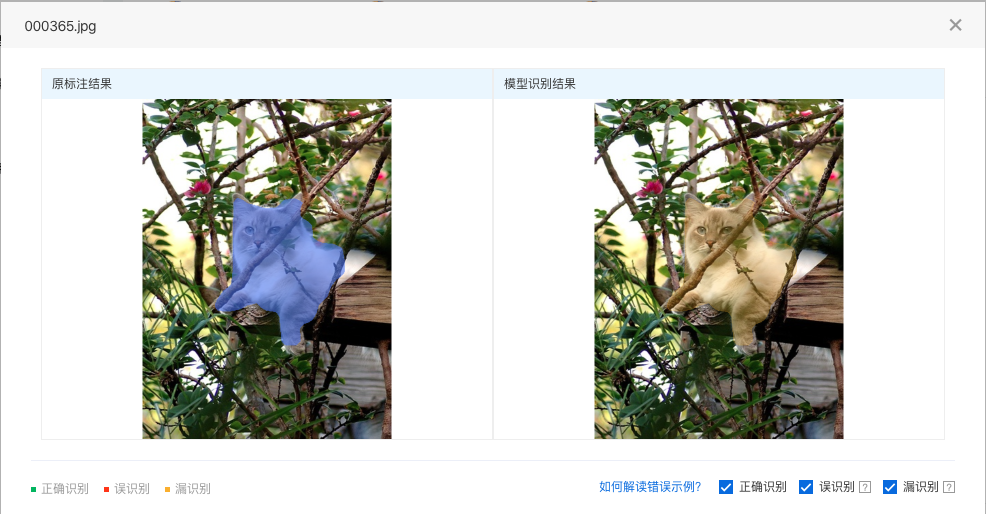

识别错误图片示例

通过分标签查看模型识别错误的图片,寻找其中的共性,进而有针对性的扩充训练数据。

如下图所示,可以通过勾选「误识别」、「漏识别」来分别查看两种错误识别的情况:

- 误识别:红色遮盖内没有目标物体(准备训练数据时没有标注),但模型识别到了目标物体

观察误识别的目标有什么共性:例如,一个检测电动车的模型,把很多自行车误识别成了电动车(因为电动车和自行车外观上比较相似)。这时,就需要在训练集中为自行车特别建立一个标签,并且在所有训练集图片中,将自行车标注出来。

可以把模型想象成一个在认识世界的孩童,当你告诉他电动车和自行车分别是什么样时,他就能认出来;当你没有告诉他的时候,他就有可能把自行车认成电动车。

- 漏识别:橙色遮盖内应该有目标物体(准备训练数据时标注了),但模型没能识别出目标物体

观察漏识别的目标有什么共性:例如,一个检测会议室参会人数的模型,会漏识别图片中出现的白色人种。这大概率是因为训练集中缺少白色人种的标注数据造成的。因此,需要在训练集中添加包含白色人种的图片,并将白色人种标注出来。

黄色人种和白色人种在外貌的差别上是比较明显的,由于几乎所有的训练数据都标注的是黄色人种,所以模型很可能认不出白色人种。需要增加白色人种的标注数据,让模型学习到黄色人种和白色人种都属于「参会人员」这个标签。

以上例子中,我们找到的是识别错误的图片中,目标特征上的共性。除此之外,还可以观察识别错误的图片在以下维度是否有共性,比如:图片的拍摄设备、拍摄角度,图片的亮度、背景等等。