模型创建与管理

更新时间:2025-04-22

1. 模型创建来源

平台支持两种模型创建方式:

1.1 基于平台任务创建

- 精调任务(Fine-tuning)

- 蒸馏任务(Distillation)

- 模型压缩任务(Compression)

1.2 基于自定义导入创建

支持通过对象存储BOS导入HuggingFace格式模型,详见导入指南

1.3 支持矩阵

各模型类型支持的创建方式如下:

| 模型类型 | 支持来源 |

|---|---|

| 文本生成 | 精调/蒸馏/压缩/BOS |

| 深度推理 | 精调/蒸馏/BOS |

| 图像生成 | 精调/BOS |

| 图像理解 | 精调/BOS |

| 向量表示 | 精调/BOS |

| 重排序 | BOS |

注:本文重点介绍基于任务的创建方式,自定义导入详见HuggingFace模型导入文档。

2. 模型创建流程

2.1 进入创建界面

- 登录千帆平台控制台

- 导航至「模型管理」→「我的模型」

- 点击"创建模型"按钮

2.2 填写基础信息

- 模型名称(必填)

- 模型类型(必选)

- 业务标签(可选)

2.3 配置模型版本

- 版本号:自动生成(V1开始递增)

- 版本描述:建议填写业务场景、使用说明等信息

-

模型来源:

- 大模型训练任务

- 大模型蒸馏任务

- 压缩模型

3. 模型创建示例

3.1 文本生成模型

基础配置:

- 模型类型选择「文本生成」

训练任务配置:

- 训练方式:大模型调优任务(必选)

- 训练作业:选择符合条件的任务(自动过滤基础模型不一致的任务)

- 训练运行:选择已完成的任务实例

-

高级参数:

- 上下文长度:默认继承训练设置(128k基础模型支持8k-128k可调)

- 分片数量:默认按AI加速卡I型最小需求设置

蒸馏任务配置:

- 训练方式:大模型蒸馏任务(必选)

- 蒸馏作业:选择符合条件的任务

- 工具链版本:默认自动匹配部署硬件

- 高级参数配置同训练任务

3.2 图像生成模型

基础配置:

- 模型类型选择「图像生成」

训练任务配置:

- 训练方式:大模型调优(参见文生图SFT说明)

- 训练作业选择(同文本生成要求)

3.3 图像理解模型

基础配置:

- 模型类型选择「图像理解」

训练任务配置:

- 训练方式:大模型调优(参见图像理解SFT说明)

- 训练作业选择(同文本生成要求)

完成配置后点击"确定"提交,模型状态将转为"创建中",成功后变为"就绪"状态。

4. 模型详情管理

4.1 访问路径

控制台 → 模型仓库 → 我的模型

注意:删除模型不影响已部署服务。

4.2 功能模块

基本信息面板

- 展示模型ID/类型/标签

- 支持业务标签编辑

版本管理

-

新增版本:

- 继承最新版本的基础模型配置

-

状态流转:创建中 → 就绪

限制:单次训练运行不能创建多个版本

-

版本操作:

任务看板

记录所有模型相关操作:

- 版本管理(创建/删除)

- 评估/压缩任务

- 导出记录(含下载入口)

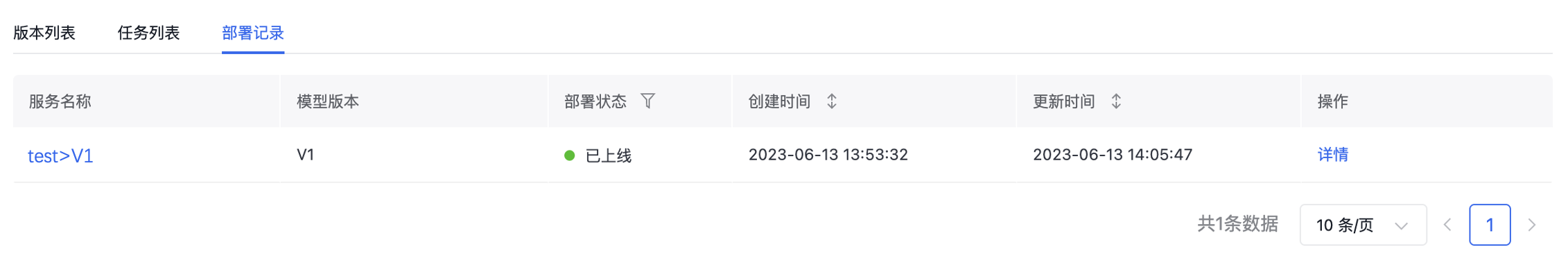

部署监控

展示各版本部署状态与服务详情: