ERNIE-Doc

更新时间:2022-01-28

ERNIE-Doc

简介

传统预训练模型(ERNIE、BERT等)的最大建模长度一般不超过512,因此在处理长度超过512的文本时,或是选择随机截断成512个字符长度,或是选择裁剪为多个长度不超过512的文本片段。上述的两种策略均会造成信息丢失或者文本语义割裂的问题,也即传统的预训练模型并不适用于超长文本的应用场景。ERNIE_DOC是一种基于Transformer-XL架构的长文本预训练语言模型。

技术原理

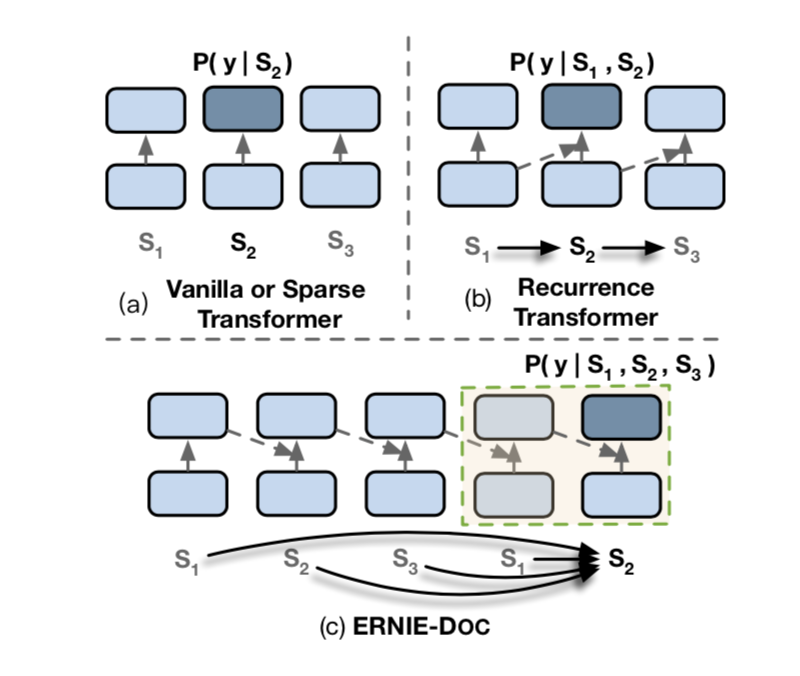

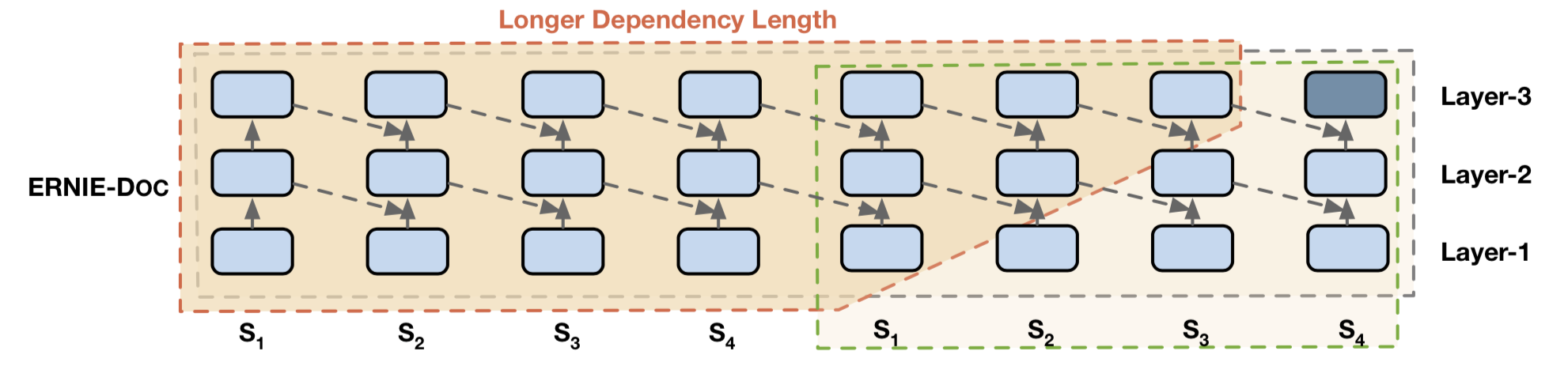

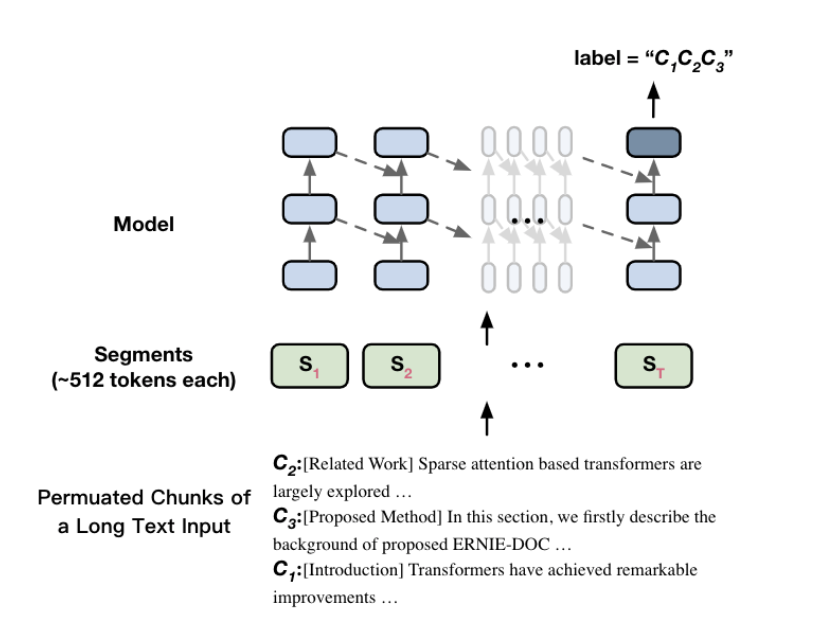

ERNIE-Doc以Transformer-XL为基础,并做了一些创新优化:

- 回顾式文本输入方法

- 错层memory传递机制

- 基于篇章的句子重排序预训练任务

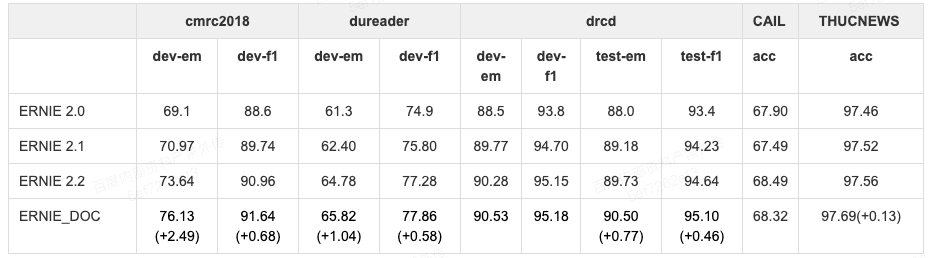

模型效果

使用方式

目前我们在长文本分类任务中提供了详细的ERNIE-Doc使用Demo,请移步长文本文本分类