ERNIE-Gen

更新时间:2022-08-04

ERNIE-Gen

简介

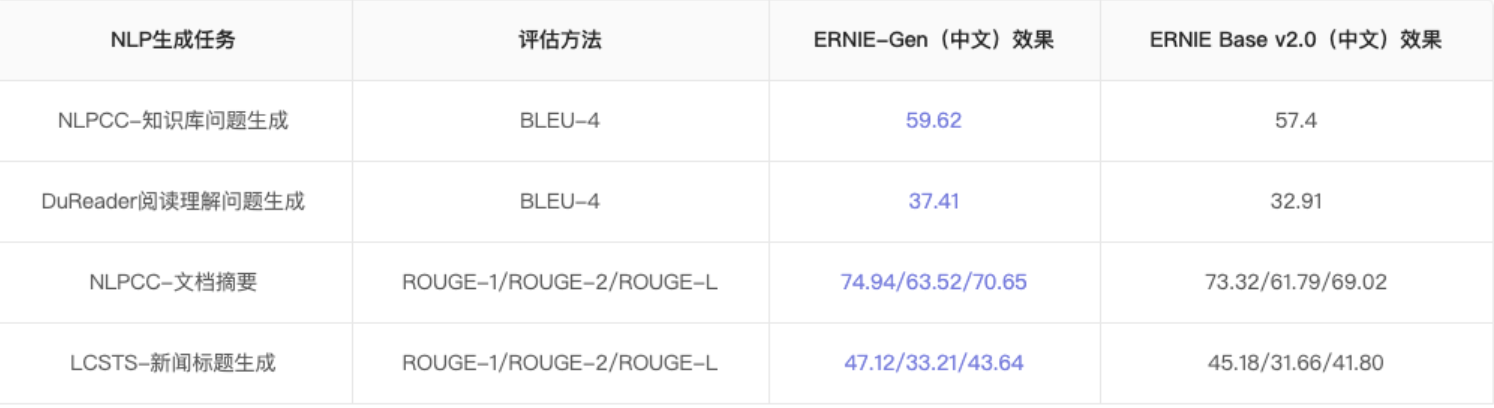

ERNIE-GEN是针对通用生成任务的预训练模型,在4类生成任务的5个英文公开数据集上超过微软 MASS 和 UNILM、Facebook BART、谷歌 T5 等参数规模更大、预训练数据更多的竞品模型取得SOTA效果,在中文任务上较通用ERNIE模型提升显著。

技术原理

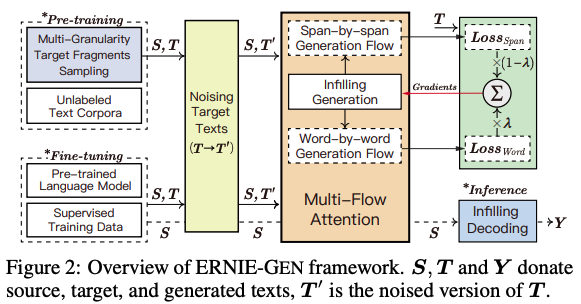

ERNIE-GEN的核心技术和创新主要体现在以下三个方面:

•针对encoder-decoder 联合建模能力较弱的问题,提出了多片段-多粒度预训练采样策略,增强了 encoder 和 decoder 的交互。

•针对seq2seq 曝光偏差问题, 提出基于 Infilling 机制的 pretrain-finetune 框架, 并进一步引入噪声增强策略。

•考虑到人类的思考模式,提出将 span 预测引入生成预训练中,增强语义学习。

详细的原理请移步论文:https://arxiv.org/pdf/2001.11314.pdf

模型效果

使用方式

目前我们在文本生成任务中提供了详细的ERNIE-Goc使用Demo,请移步文本生成